※この記事はDevicePlus.com(英語版)のこの記事を日本語訳したものです。

ウェアラブルおよびIoT技術が毎日の生活に流入するようになり、身体機能や習慣に関して、かつてないほど大量のデータが収集されるようになってきました。ぐっすり眠れましたね、水分摂取が必要ですよ、深呼吸をしてストレスを解消しましょう・・・そんなことをモニター機器が教えてくれるようになってきています。とはいえもちろん限界があります。機械は人の思考や動機まで左右することはできません。人間の行動を後押しする動機を測定するには、人間と機械との関係を一段階上げていく必要があるのです。

人間とは感情的な生き物です。感情によって消費者行動は左右され、環境との相互作用の仕方も変わってきます。そしてその逆もまた然りです。しかし感情とは非常に曖昧なものです。人間の感情の複雑性を、論理的にプログラミングされたコンピュータデバイスに理解させることは果たして可能なのでしょうか?

パロアルトに拠点を置くEyeris社は、この挑戦に立ち向かっています。同社は、人工知能視覚センサ埋込ソフトウェアを用いて感情を検知することのできるデバイスの開発を進めています。EmoVuは、カメラ付の各種デバイスによって検知した顔の些細な表情を分析し、喜び、悲しみ、驚き、怒り、嫌悪、恐怖、無感情を表す普遍的な表情として登録します。さらに性別、人種、年齢層、頭部位置、視線、顔認識等についても認識し、最終的にユーザー特定(年齢、性別、人種等)およびユーザーの感情に関する、リアルタイムで高精度の分析結果を提供します。

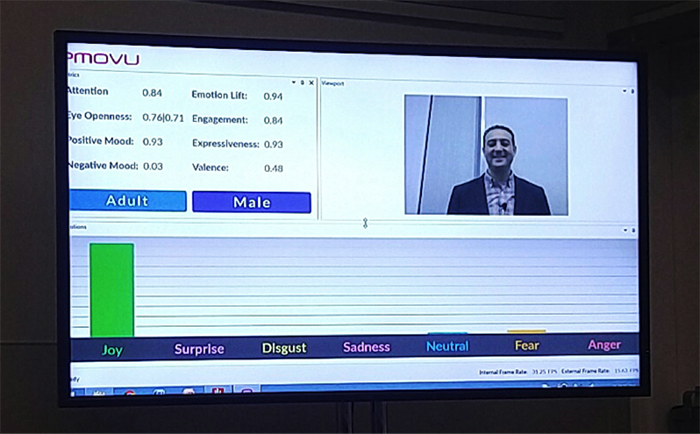

写真1. EmoVuソフトウェアで追跡、解析可能な感情7種およびその他項目/©Eyeris

写真2. Wearables TechConでEmoVuのデモを行うEyeris社創業者兼CEO、JR Alaoui氏。同ソフトウェアでは、

笑みの表情を喜びの感情として登録。

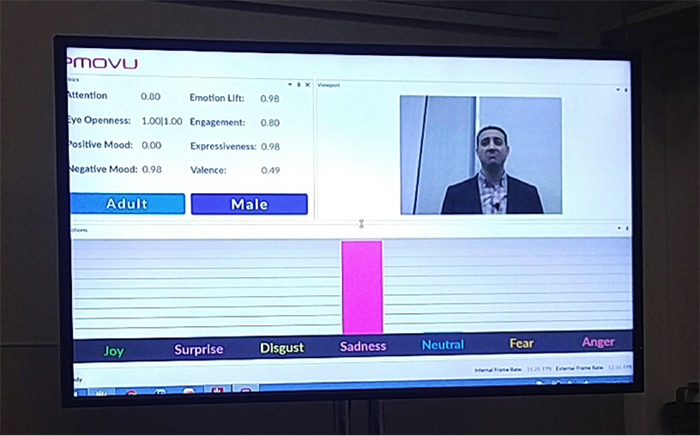

写真3. EmoVuソフトウェアでは、眉をひそめた表情を悲しみの表情として登録。

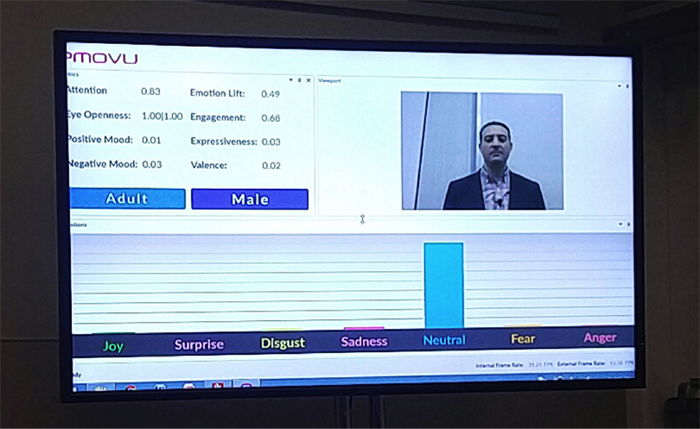

写真4. EmoVuソフトウェアでは、無表情を無感情として認識。

Eyeris社独自のディープラーニングベースのアルゴリズムは、畳み込みニューラルネットワーク(CNN)を採用して、画像処理および連続学習を行うものです。同社のデータセットは、主要な人種/民族、年齢層、性別、姿勢、属性(眼鏡、帽子等)、照明環境等の広範な画像を解析して生成されたもので、人工知能による包括的なサンプリングおよび統合によって、より高精度の環境知能(AmI)を実現しました。環境知能(AmI)とは、検知し、人間に反応する能力を電子的にもたせた環境のことです。EmoVuはアダプティブ・ラーニング(適応学習)によって、高精度のユーザー特定を可能とし、ユーザーと環境との質の高い相互作用を実現させます。

感情および属性を捉える能力によってEmoVuは、ユーザーがゲーム、アプリ、ウェブサイト等とインタラクションする際に有用なフィードバックを提供できるツールとなりました。アプリケーション開発時に、EmoVuの機能をデスクトップSDK、モバイルSDK、クラウドAPIに組み込むことが可能です。モバイルSDKは、情報を端末でローカル処理し、別のアプリケーションからのアクセスを可能にすることができます。EmoVuの機能を活用することで、開発にあたって、大規模なコンピュータオーバーヘッドを要することなく、ユーザーの感情的な反応に基づくユーザエクスペリエンス(UX)を向上させることが可能となるのです。

写真5. Wearables TechCon 2016で、「人工知能視覚センサを用いた心の知能指数(EI)ウェアラブル」についてプレゼンするEyeris社CEO、JR Alaoui氏

Eyeris社創業者兼CEOのModar (JR) Alaoui氏は、Wearables TechConで開発者らに向けて、EmoVuがウェアラブルおよびIoT機器に対して、いかに機能性を高め、状況認識力を向上させるかについてプレゼンしました。インタビューで氏は、埋込カメラが生活の中にどんどん入ってきており、それによって、人、場所、モノという3点に関する認識がさらに高まっているということに触れました。顔認識は、ある状況においてその人を分析する際最も重要な要素です。つまり、「その人にある行動を取らせるにはどうすべきか、その人が次にどのような行動を取るかをいかに予測できるかといったことや、あるいは、それは誰なのか、性別は、年齢層は、頭部位置は、何を見ているか、目は開いているか閉じているか、さらに最も重要なこととしてどのような感情を有しているか等を認識することで周囲の環境をカスタマイズする仕方」・・・こういったことを顔認識によって把握することができるのです。同社の目的は、環境またはアプリケーションをカスタマイズすることでユーザーを積極的にサポートすることであり、顧客のインタラクション経験を向上させるべく模索している企業に対して、人の行動に関するフィードバックを提供することでその目的を実現することなのです。

EmoVuがウェアラブル端末に組み込むには最適である理由として、機能の複雑性にもかかわらず、アルゴリズムのフットプリントが小さく(1 mB未満)、RAM、ROM、保存スペースが些少で済むという利点が挙げられます。埋込システムのサイズを制限するウェアラブルの小型化フォームファクターにとって、この点は非常に重要です。

また、ローカル処理もフォーマットされており、リアルタイムデータ解析が可能です。ウェアラブルにとってデータのプライバシーは大きな課題であり、画像の調達、保存には法律上の問題があります。EmoVuはプライバシーに関する世界中の全法律に準拠しており、全画像、映像は破棄され、データ解析のみが保持される仕組みになっています。

Alaoui氏はプレゼンの中で、感情検知機能の医療分野への応用についても触れました。自閉症患者にとって刺激が強く、興奮状態が生じようとする場合、教師や介護者に警告するという方法でフィードバックを提供することができるということです。またPTSDのトリガーについても特定できるということです。

中立的なフィードバックシステムを有する同製品はまた、疼痛処理にも有効です。患者がうまく言葉で表せない不快感を有している場合などに、表情解析による感情検知によって、医療者に知らせることが可能となります。また患者のトリアージ(疼痛の深刻度に基づいて優先順位を付ける)にも応用できるでしょう。概してこの技術は、疼痛に関する自己報告を補う補足データとなり得るものであり、より正確な診断、治療の一助となると言えます。

この技術を医療インフラに組み入れて医療の自動化を向上させる、ということではなく、疼痛レベルの判断において、より高品質、より高精度の診断を実現する一助とすること、それが氏の期待することです。そして、コンピュータ上でしか意思伝達ができないようなEヘルスや遠隔治療等において、カメラ付デバイスを使用することで、この技術は非常に有用なツールとなり得ると氏は考えています。「例えば、コンピュータ上に仮想医師がいて、患者の顔色や調子を見て、全体的な表情から、前日との違いをリアルタイムで比較することもできます。目の開き方はどうか?瞳孔拡張は?充血は?等々・・・顔から読み取れることはたくさんあり、こういったことで医療業界に貢献できるでしょう。」

医療用ウェアラブルは現在非常に注目されている分野であり、感情認識ソフトウェアによって提供される高い機能性について、今後さらに活用が進められていくでしょう。

この技術の応用分野として関心ある分野は何かという質問に対してAlaoui氏が挙げたのは、運転手モニタリングとソーシャルロボティクスの2分野でした。まず、運転手モニタリングでは、特に自動運転自動車において、運転手の不注意、覚醒状態、注意の散漫を同ソフトウェアによってモニターできるということについての説明がありました。自動運転自動車は自動運転を行いますが、システムの不具合や危険な道路状況という場合もあるため、運転手の介入、つまり、完全自動運転からマニュアル運転への切り替えに、運転手は常に備えておく必要があります。ですからマニュアル運転に入る前に、カメラが運転手の顔を捉えて、「運転手が運転可能状態にあるかどうか、つまり、目は開いているか、頭部位置はまっすぐで、マニュアル運転を行える状態にあるか」を確認するのです。

この技術はまた、マニュアル運転から自動運転への切り替えにも役立つでしょう。運転手に眠気や不注意が現れたらフィードバック信号を送信し運転手に警告する、あるいは、身体的な緊急事態等、一定の危険に達した場合、完全自動運転に移行する、といった使い方が可能です。

写真6. EmoVuは、運転手の注意力に関するフィードバックを提供/©Huffingtonpost

Alaoui氏が関心を持っている第2の応用分野は、ソーシャルロボティクス、主としてソフトバンク社のペッパー、ジーボ、バディ等のコンパニオンロボットの分野です。これらのロボットはそれほど高額ではなく、こうしている間にも何十万体も生産されています。2017年、ソーシャルロボティクス分野がいかに成長を遂げるかということについて、氏はこのように話しています。「例えばAmazon社のEcho。これの第2、第3世代がカメラ内蔵型になり、カメラで人の顔を確認しながら会話するようになる。新規開発者がどんどん現れ、例えばゲーム、Eラーニング、セラピーロボット、高齢者用製品等、この機能を使ったアプリケーションがどんどん開発される・・・このように、ソーシャルロボティクスは、まさに2007年のiPhoneのように爆発的な存在となると私達は信じています。」EmoVuの顔認識、感情認識機能によって、ソーシャルロボティクスの分野が今後爆発的に拡大することは間違いありません。そしてそのことは、Eyeris社にとっても大きく成長するチャンスともなるでしょう。

感情モニター機能を有するEmoVuは、カスタマイズおよびインタラクションのレベルが格段に向上したデバイスを日常的に使用することになるであろう未来への懸け橋になることは間違いありません。独自のSDKやクラウドAPIの開発に活用することで、モバイルアプリやカメラ付デバイスの新しいユーティリティに、この技術がどんどん採用されることになるでしょう。感情および属性フィードバック機能が有する価値は一言では語れないほど高いものであり、EmoVuは医療、運転手モニタリング、消費者評価、ソーシャルロボティクス等、ウェアラブルおよびIoT分野に幅広く組み込まれていくと思われます。身の回りの定量化が進み、環境が応答的になっていくにつれ、人間のニーズを検知し、理解し、それに対応するために、EmoVuのような感情認識ソフトウェアが中心的な役割を果たすようになっていくことでしょう。

執筆:Amanda Mintier

Wearables TechCon 2016シリーズ:

- まとめ―ウェアラブル技術の未来を一挙公開

- 医療用ウェアラブル―医療用ウェアラブル:SFの世界が現実に

- 小型ウェアラブル―ウェアラブルのスペースに関するMEMS設計上の課題を克服